Services

大規模言語モデルと既存技術を組み合わせることで、様々なドキュメントから欲しい情報を抽出可能に

大規模言語モデルの出現により、情報抽出は格段に容易になりました。しかし、大量ファイルの処理、期待したフォーマットでの出力、システムの一機能としての実装などは、技術ノウハウなしには困難が伴います。

弊社では、大規模言語モデル一辺倒ではなく、既存の様々な有効なツールやアルゴリズムと組み合わせることで、高精度かつ実運用向けのツールとして提供します。

文字情報抽出の従来の課題

- 画像データやPDFデータなど、世の中にはまだまだ多くの非構造化データが日常的に使われています。

- そのため、本来必要のない無駄な作業の発生や、データの利活用の妨げとなっています。

- 機械学習の発展により抽出の精度は向上しましたが、不定型フォーマット文章からの抽出や、PDF中の不均一な表形式からの抽出など、課題は多く残っていました。

大規模言語モデルによる大幅な精度向上、しかし、丸投げでは失敗する

- ChatGPTをはじめとする大規模言語モデルの登場により、抽出精度は格段に向上しました。

- しかし、ChatGPTにファイルを投げ込むだけでは、なんとなくの結果は出ますが、実運用で使うには難しい状況に陥ることが多いのが現状です。

大規模言語モデルと既存技術との適切な融合が成功への鍵

画像やテキストの処理に関しては、様々な既存のツールやアルゴリズムが存在しています。

対象となるファイル形式や、文字情報の不定型度合いなどを考慮に入れて、それらを適切に使いこなしつつ、その上で、ChatGPT等の大規模言語モデルを融合させることが重要になってきます。

これにより、「精度の向上」、「高カスタマイズ性」、「高い実運用性」を実現することができます。

弊社では、実運用での利用をすでに複数支援しております。お困りごとや今後の利用の相談など、お気軽にご相談ください。

【デモ】

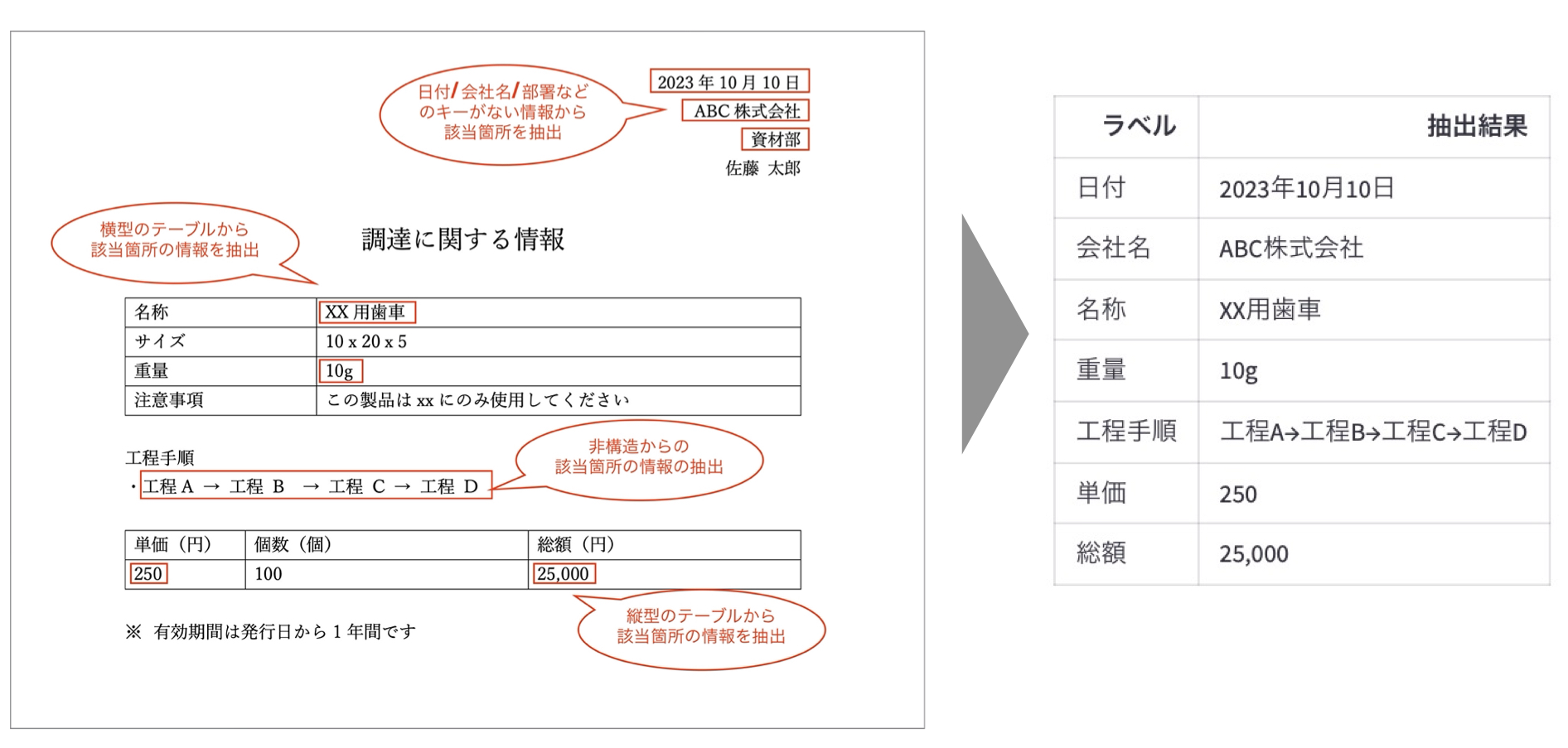

不定型フォーマットで構成されたドキュメント画像からの情報抽出

- 請求書やエクセルで作成された定型のドキュメント画像だけでなく、wordなどで作成された不定型のドキュメント画像や、スマートフォンのカメラで撮影した画像など、幅広いドキュメント画像に対して、精度が高いテキスト情報の抽出が可能

- 下記はアップロードした画像ファイルから、対話的にラベルを指定しながらエンティティを抽出するデモです

ドキュメント中に点在する情報を抽出し構造化データへ

【ユースケース】

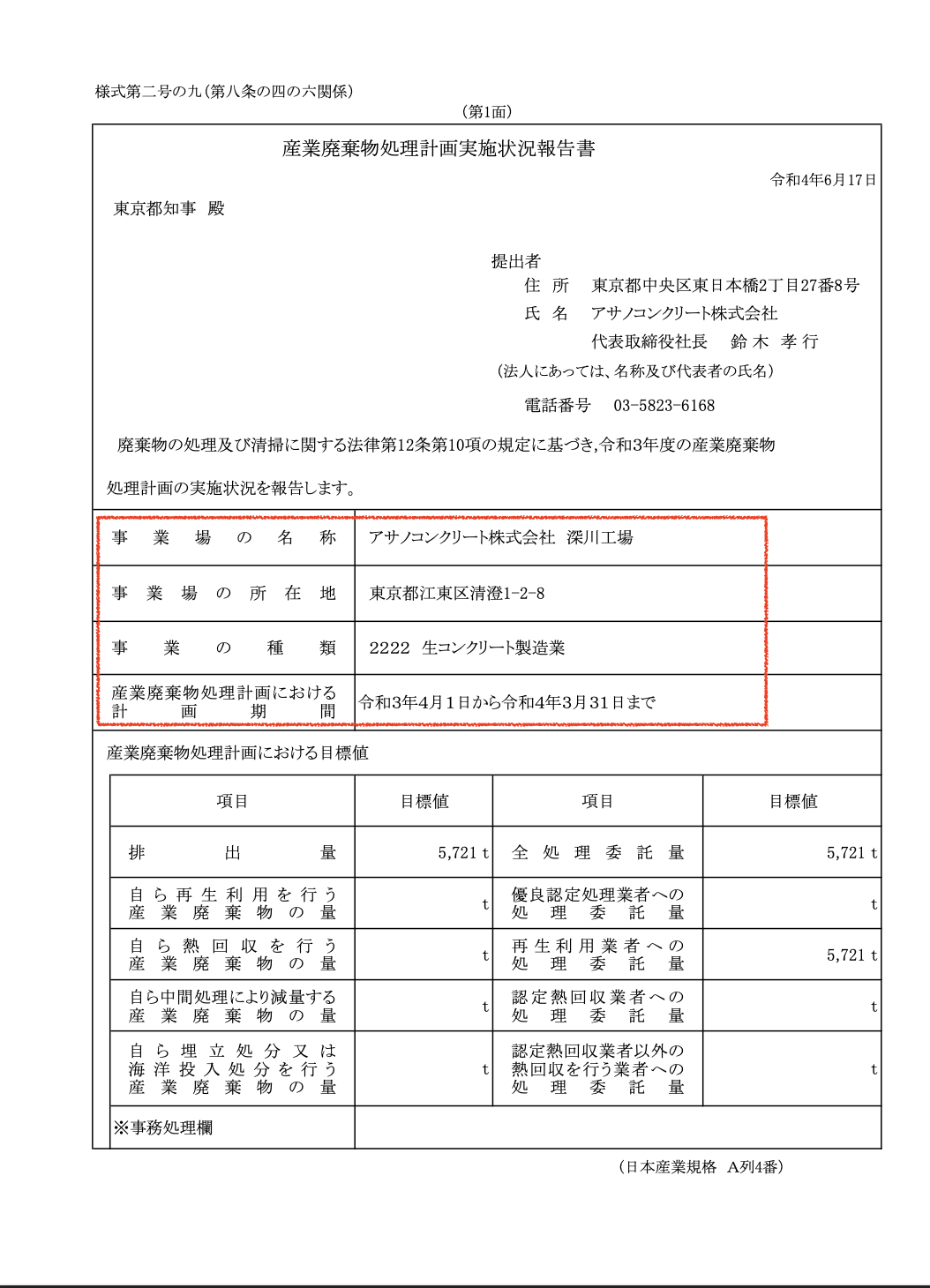

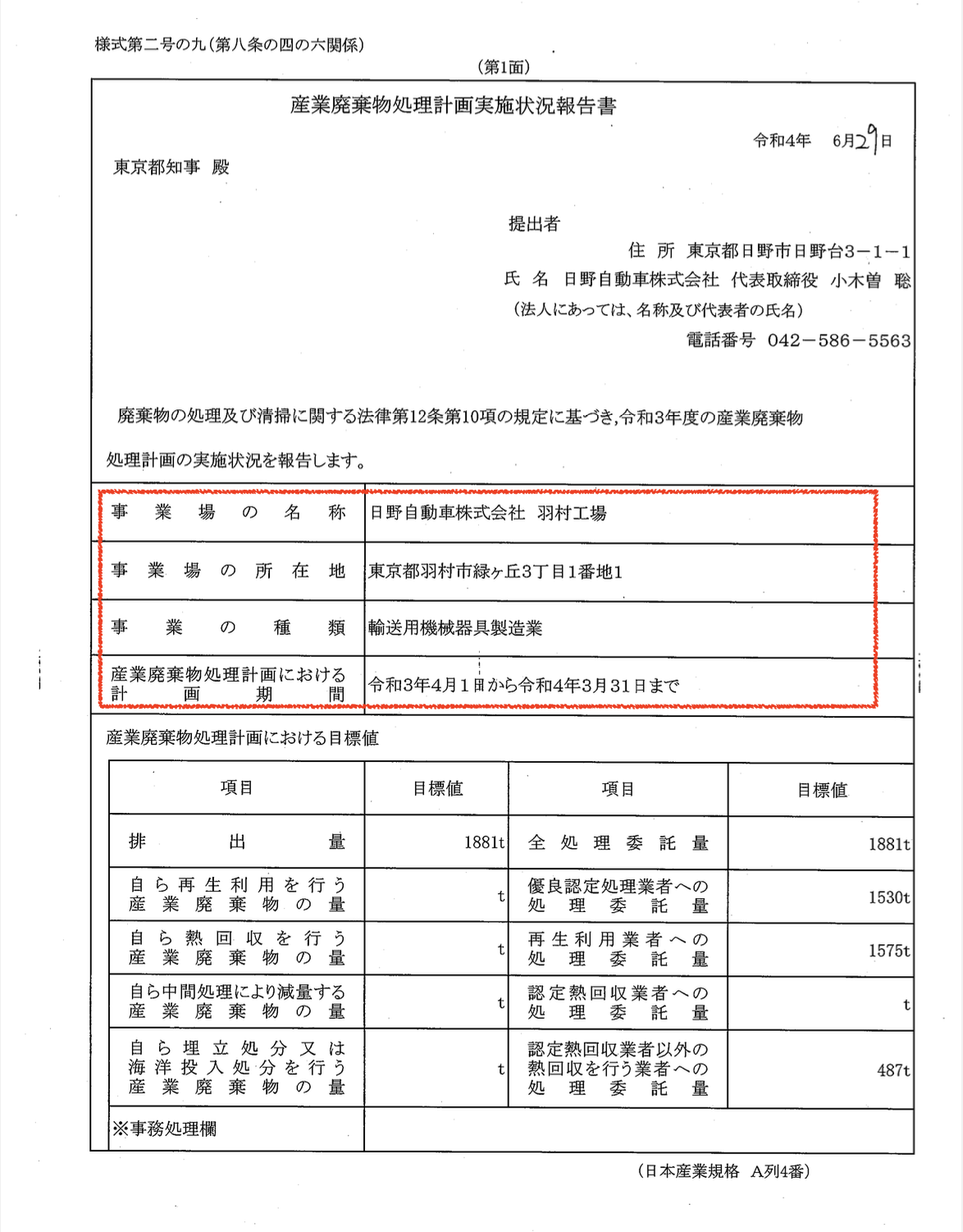

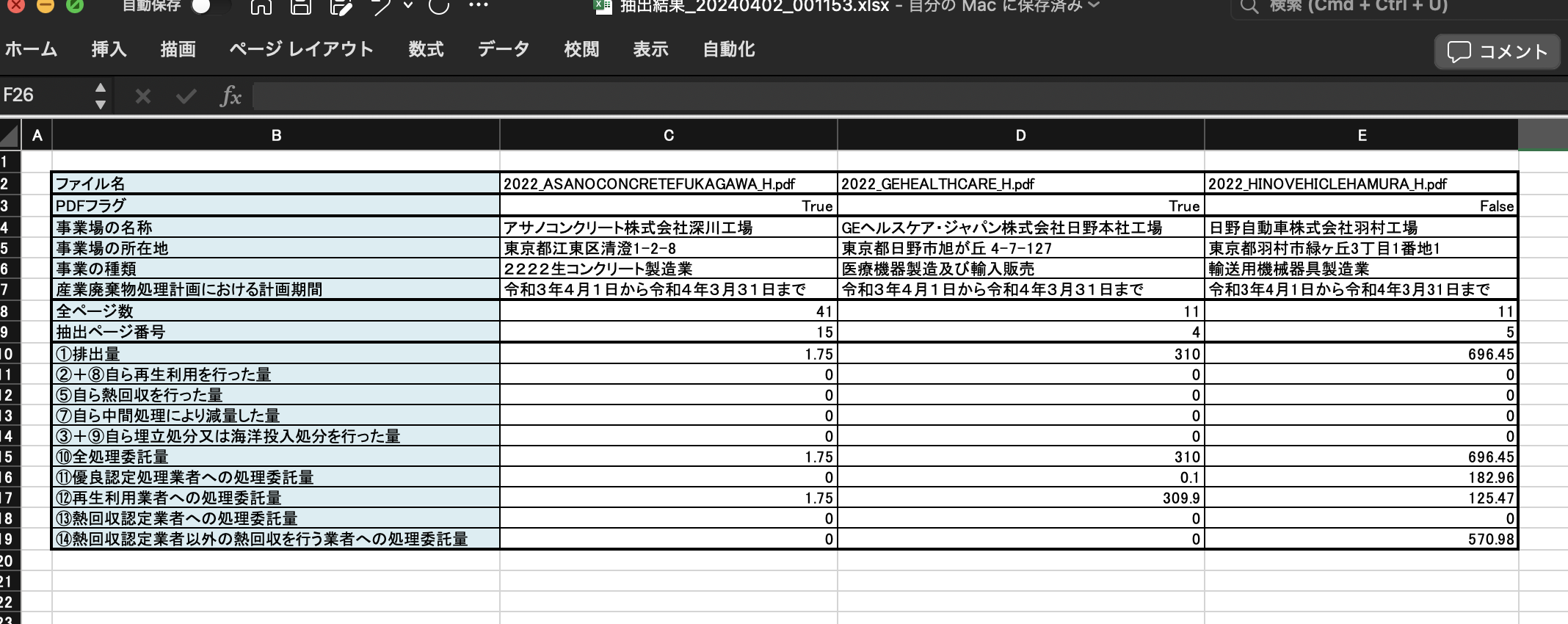

廃棄物情報が記載されたPDFファイルの一括処理と構造化データの作成

- 下記では、以前、東京都が公開していたPDFファイルから、企業名や廃棄物に関する数値を抽出し、構造化データとしてまとめます。

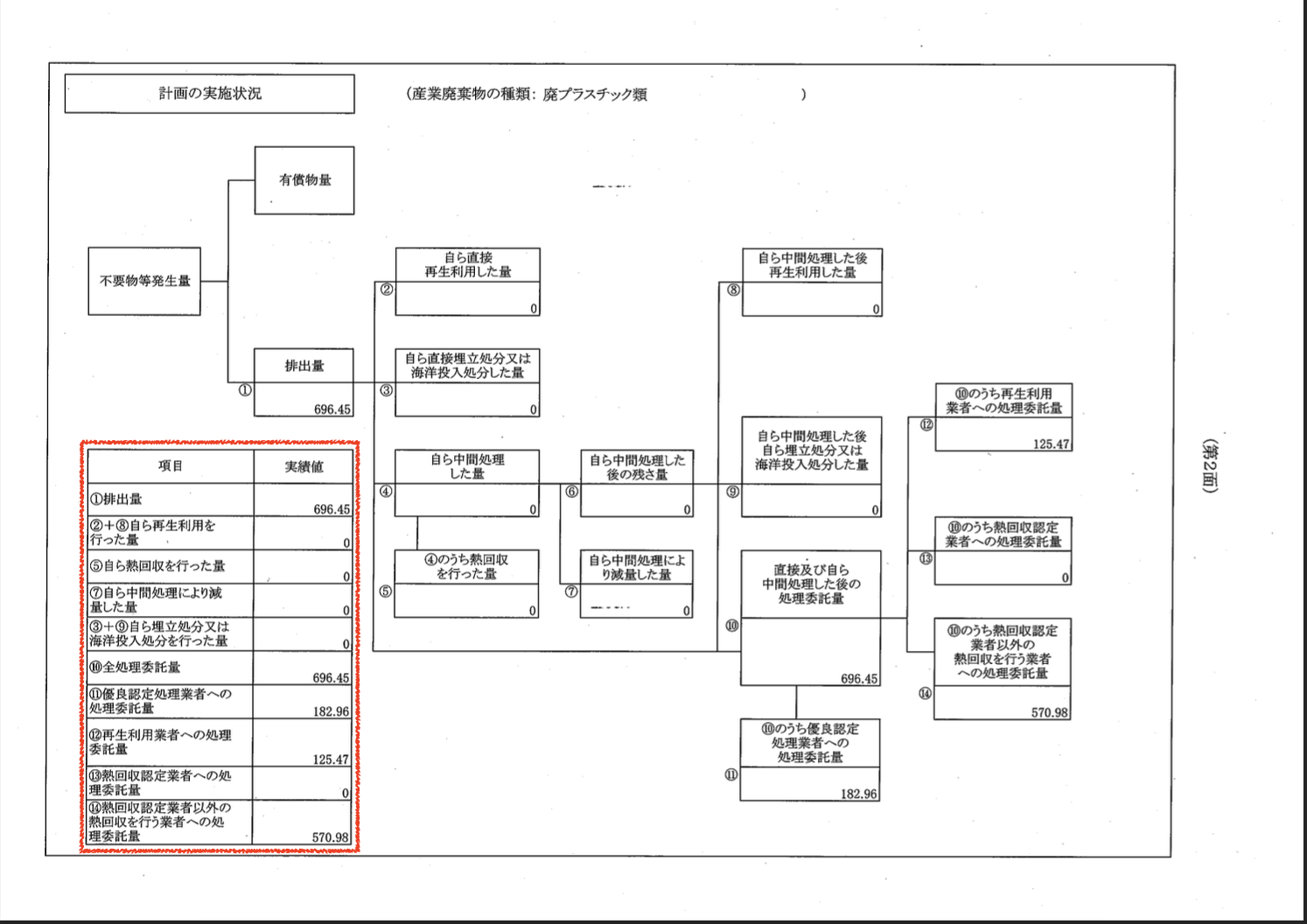

- 抽出したい情報は、1ページ目の企業情報と、廃プラスチックの数値情報です。廃プラスチックの情報は、複数ページの任意のページに記載があるため、該当ページを特定したのちに値を抽出する必要があります。また、PDFファイルによってはPDFパーサーで抽出ができないファイル(画像である場合もある)が含まれていることも多くあります。

- このように、PDFファイルの一括処理では、「一般的なPDFのパーサーで処理できないファイルが含まれていたり」、「複数ページ中から該当箇所の特定が必要であったり」といった課題が存在します。

- ここでは、「大規模言語モデルと既存の複数の処理技術を組み合わせる」ことで、自動的に一括処理がなされ、指定したフォーマットのエクセルを作成します

PDFファイル1(41ページのPDFファイル、一般的なPDFパーサーで抽出可能)

- 1ページ目に概要が記載

- 15ページ目に廃プラスチックに関する実績値が記載

PDFファイル2(11ページのPDFファイル、一般的なPDFパーサーで抽出が不可能なファイル)

- 1ページ目に概要が記載

- 5ページ目に廃プラスチックに関する実績値が記載

抽出結果

- PDFかどうかを自動的に判定し、PDFパーサーとそれ以外の処理を自動的に実行しテキストの抽出作業を実施

- 各PDFの1ページ目から企業情報を抽出

- 各PDFの複数ページの中から抽出するページを特定し、表形式から必要な数値を抽出

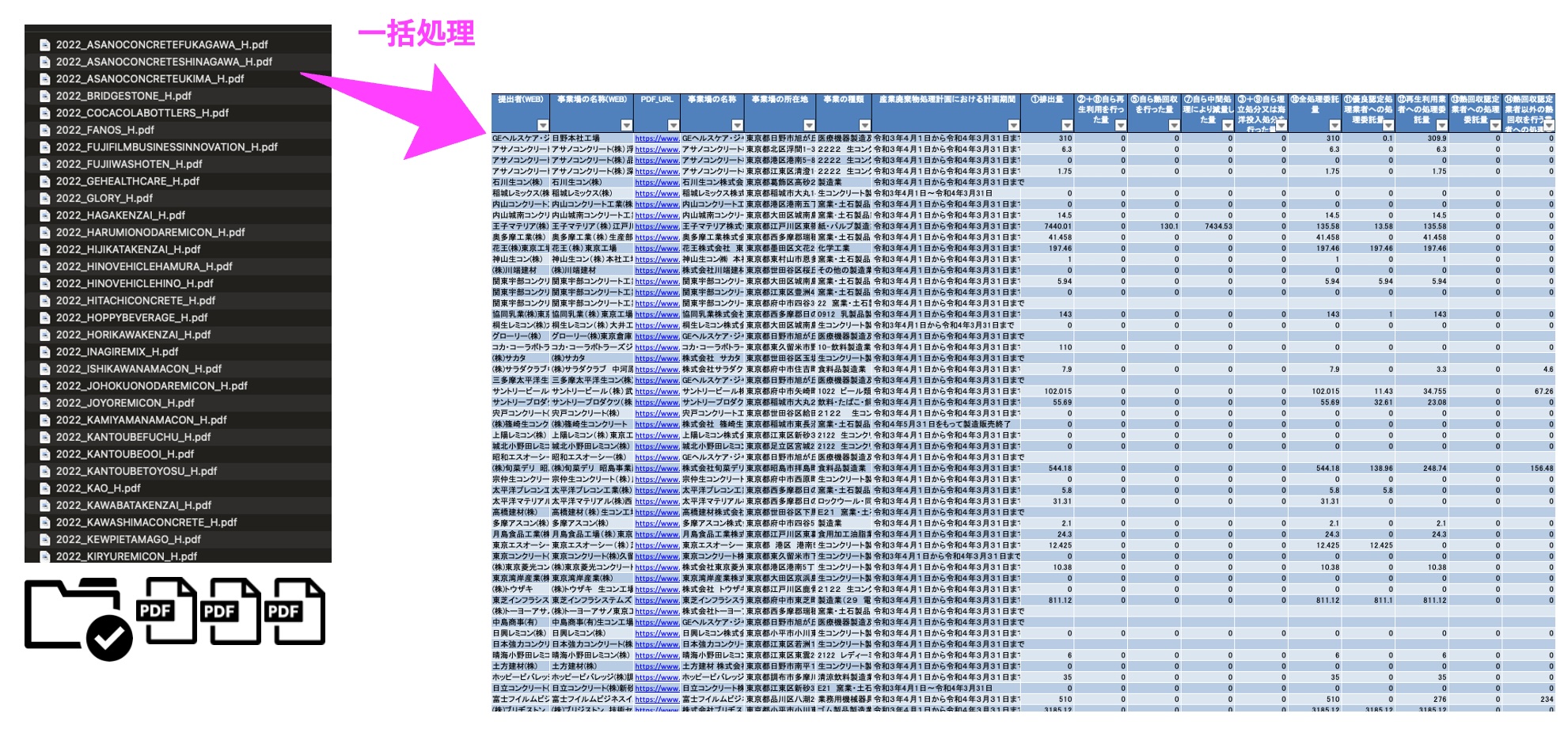

大量のPDFの一括処理によるデータ化

- 大量のPDFファイルを一括処理してのデータ化も可能

【ユースケース】

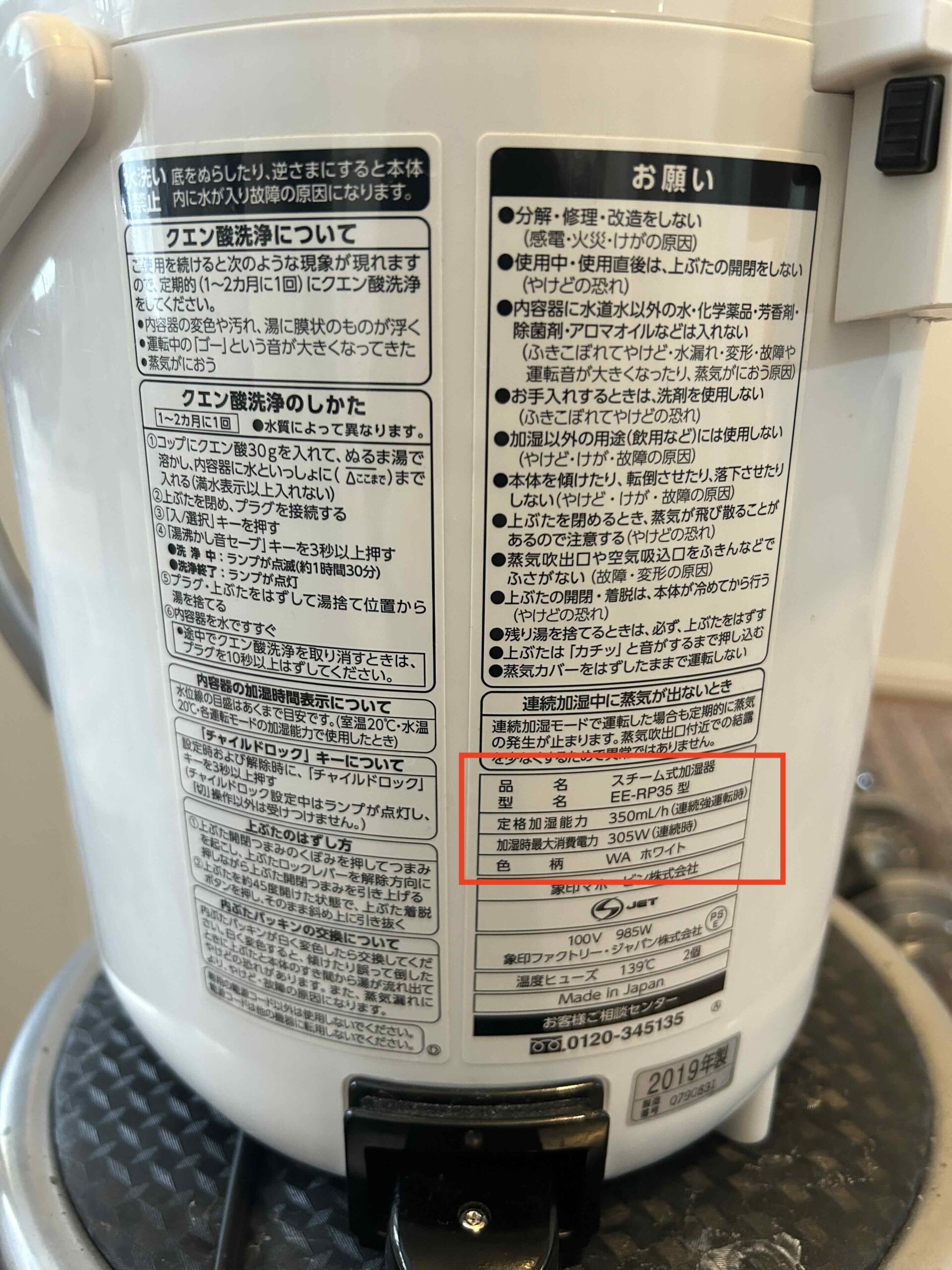

撮影されたラベル表示からの情報抽出

- ラベル等の撮影画像から情報抽出は、フォーマットが不定形であったり、湾曲による文字が読みづらい等の問題があります。

- 例えば下の例では、家電製品のラベルを写真撮影した画像です。

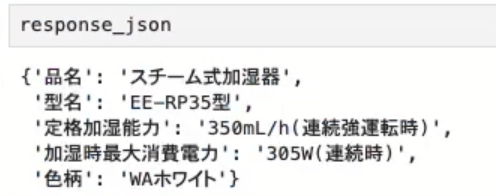

- 弊社の抽出エンジンAPIを使うことで、このような画像からも精度良く文字情報の抽出が可能です。加えて、json形式での出力も可能なため、システム連携も可能です。

家電製品のラベル撮影画像(赤字が抽出対象)

抽出エンジンAPI

抽出結果(json形式)

ファインチューニングによるGPT利用時のコスト削減

GPTを実運用すると費用がボトルネックに

GPTを数千、数万件オーダーでAPIにて運用すると、精度とは別に費用の問題が生じてきます。現状、GPT4-turboで1回あたり数円かかります。1回あたりは僅かですが、月で数千、数万回呼び出すとなるとそれなりの金額になってきます。

GPT3.5-turboだと、GPT4-turboの1/20程度の費用で済みますが、実運用で使える精度が出ないことが多々あります。

fine-tuningモデルの利用で運用コストを1/4に削減

そこで弊社では、GPT3.5-turboをファインチューニングすることによる、運用コストの抑制にも取り組んでいます。

GPT3.5-turboのファインチューニング費用は1000〜数千円程度掛かりますが(データ量に依存します)、ファインチューニングがうまくいけば、GPT4-turboの精度を維持したまま、コストを1/4程度に削減することが可能になります。

生成AI(LLM)を活用した、データ抽出やデータ作成に関するお悩みやご要望などありましたら、ぜひお聞かせ下さい!

- WEB上にある大量のファイルから情報を抽出してデータ化したい

- 日々手入力している不定型フォーマットのドキュメントを自動的に処理したい

- 大量ファイルをアップロードするとエクセルファイルを出力するWEBアプリを作って欲しい

- json形式で抽出結果を返すAPI機能が欲しい

などなど、様々な要望にお応えします。

Accelerate Your Business Growth With Us

HOME

- About Us

- Service

- Development

- Usecase

COMPANY

- Member

- VisionMission

- 会社概要

Privacy Policy

HELIKS DATA Inc.

東京都品川区西五反田二丁目14番13号ニックハイム五反田2階